迪士尼研究院最新语音动画研究可实现更逼真的社交VR

2017-08-17 粤港澳大湾区城市群网YGA.CN

2017年08月17日,迪士尼研究院联合几所大学的研究人员撰写的一篇新论文,其描述了一种根据深度学习实现程序语音动画的新方法。该系统可以对人类录音进行采样,并自动生成匹配的口型动画。这种方法的应用范围十分宽广,比如提高动画管道的效率,以及通过实时绘制用户讲话时的虚拟化身口型动画来使社交VR交互更具说服力。

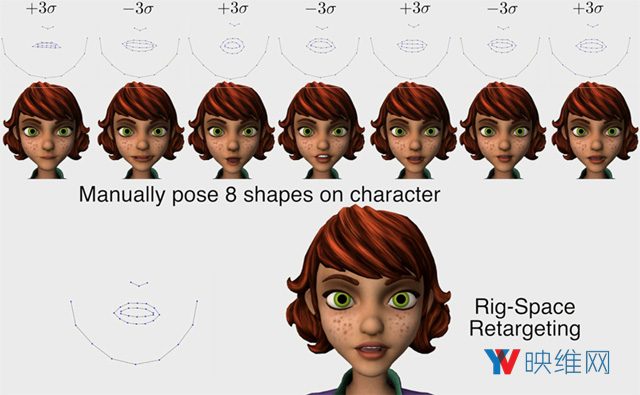

迪斯尼研究院,东安格利亚大学,加利福尼亚理工大学和卡内基梅隆大学的研究人员撰写了题为“A Deep Learning Approach for Generalized Speech Animation”的论文,其描述了一种已经通过“深度学习/神经网络”方法进行训练的系统,通过单个扬声器的参考片段(2543句)来教导系统在各种语音单元(音素)期间应该形成的形状及其组合,时长达8小时。

经过训练的系统可用于分析来自任何扬声器的音频,并自动产生相应的口形,然后将其应用于自动语音动画的面部模型。研究人员表示,该系统独立于扬声器,可以“近似计算其他语言”。

“我们使用了一种简单有效的深度学习方法来自动生成与输入语音同步的自然寻像语音动画。我们的方法使用了滑动窗口预测器,其能够准确捕捉自然运动和视觉协同发音,学习从语音标签输入序列到口部运动的任意非线性映射。我们的深度学习方法具有以下几个吸引人的特性:实时运行;需要最少的参数调整;能很好地归纳新颖的输入语音序列;容易编辑出风格化和情感化的语音;以及兼容现有的动画重定向方法。”

创建与CGI角色音频记录相匹配的语音动画通常由熟练的动画师手工完成。尽管这个系统不能满足大型CGI制作对高保真语音动画的需求,但可以用于这种制作中的自动1PASS,或者是在特定情况下添加可接受的语音动画,例如大型角色扮演游戏中NPC对话,或者是从语音动画中受益的低预算项目(没有办法聘请动画师),如教学/培训视频,学术项目等。

至于VR,这种系统可以在用户说话时实时动画化虚拟化身的口型,从而使得社交VR角色变得更加逼真。真正的口型追踪(光学或其他)是制作虚拟化身语音动画的最准确方法,但在口型追踪硬件变得普遍之前,这样的程序语音动画系统可能是一种有效的权宜之计。

一些社交VR应用已经在使用各种系统实现语音动画,比如Oculus为Unity提供了一个唇形同步插件,基于音频输入来制作虚拟化身的口型动画。然而,这种基于深度学习的新系统似乎提供了非常高的准确性和细节度。

科技 3D

科技 3D